Вопрос, который давно следовало задать. Насколько опасна кибератака на искусственный интеллект?

Результаты исследования, проведенного специалистами Гарвардской медицинской школы в Бостоне (США), свидетельствуют о том, что системы на базе искусственного интеллекта, предназначенные для анализа медицинских изображений, не защищены от атак, призванных обмануть их способом, который останется незамеченным человеком.

Причем, как утверждают исследователи, для проведения таких кибератак могут существовать очень значительные стимулы, связанные с мошенничеством или другими не менее гнусными целями.

По словам одного из авторов исследования специалиста в компьютерных науках и биомедицинской информатике в Гарвардской медицинской школе Самюэля Финлейсона,

Наиболее поражающим меня, как исследователя, фактом является то, что провести такую атаку исключительно легко. В реальности это относительно простой процесс, который, к тому же, легко автоматизируется. Кроме этого, я был удивлен, почему уязвимости таких систем до сих пор остаются относительно неизвестными медицинскому сообществу.

Системы на базе искусственного интеллекта (нейронных сетей глубокого обучения) сегодня имеют очень большие перспективы для анализа медицинских изображений. Мы многократно писали о таких проектах, одним из главных участников которых является компания IBM Watson. В частности, совсем недавно американские регулирующие органы выдали разрешение на использование первой подобной системы, которая может использоваться для медицинской диагностики без какого-либо участия людей. По словам Финлейсона,

Мы как общество можем очень многое выиграть при внедрении таких систем в здравоохранении, но мы также должны полностью осознавать, какие недостатки они имеют.

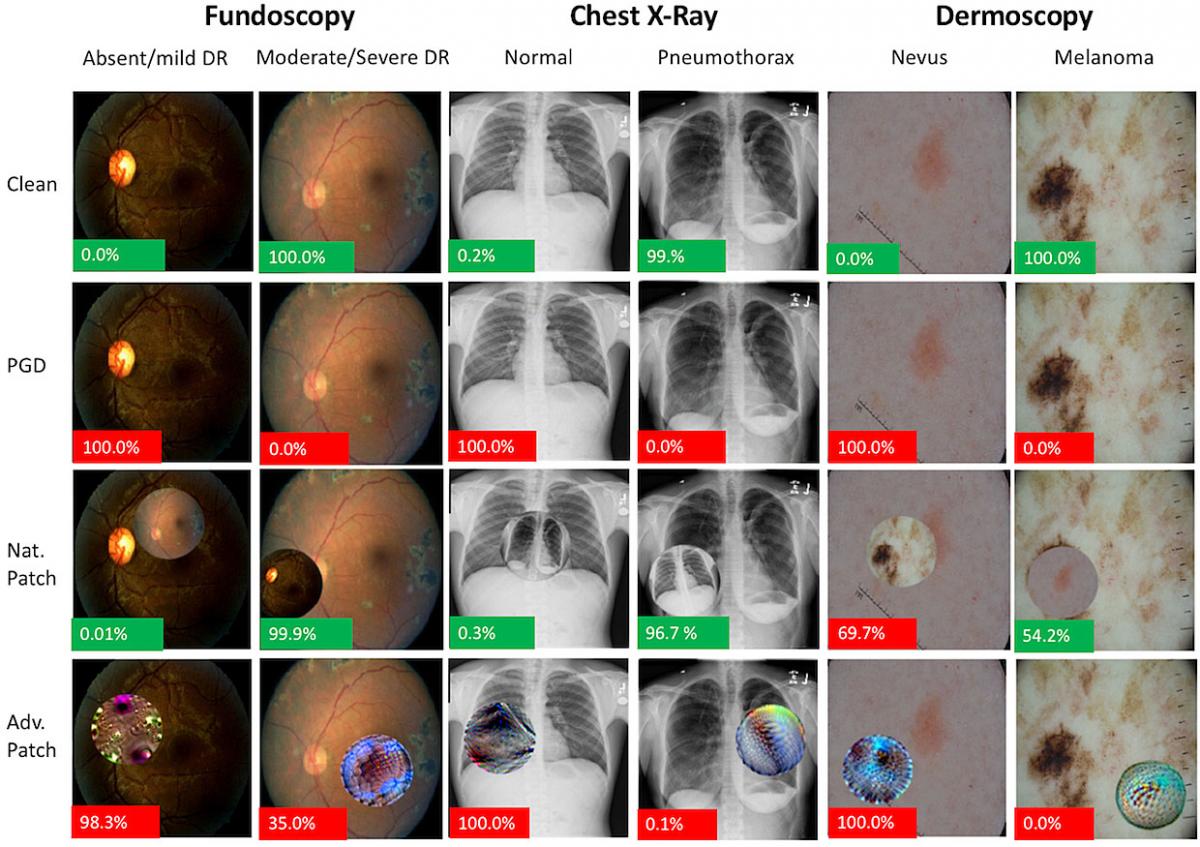

Исследователи решили проверить, насколько трудно ввести в заблуждение систему анализа медицинских изображений. Разработчики обычно регулярно тестируют алгоритмы глубокого обучения с помощью т.н. "враждебных образцов", специально сделанных для того, чтобы определить ограничения текущих методов глубокого обучения. В этом исследовании использовали такие методы при выполнении трех популярных задач - обнаружении диабетической ретинопатии по изображениям сетчатки, пневмоторакса по рентгеновскому снимку груди и меланомы по фотографии кожи. При этом некоторые пиксели в этих изображениях были модифицированы таким образом, что человек их воспринимал как минимальные искажения, а компьютерный алгоритм некорректно их классифицировал.

Как установили ученые, подобная атака в 100% случаях заставляла систему на базе алгоритма искусственного интеллекта ошибаться, при том, что модификации изображения оставались незамеченными для человеческого глаза. Причем, подчеркивают они, такая атака может касаться изображения любого типа и, более того, она может быть встроена непосредственно в процесс захвата изображения.

Для того, чтобы подобные системы на базе алгоритмов глубокого обучения были атакованы преступниками, есть много вполне возможных причин. Как отмечается в отчете, для модификации изображений сетчатки причиной может стать желание страховщиков уменьшить количество хирургических операций, за которые они вынуждены платить. Что касается рентгенограмм груди, то исследовательские фирмы могут захотеть таким образом получить желаемые для себя результаты. Особенно учитывая, в какие деньги сегодня обходятся разработки лекарственных препаратов, и какие деньги можно заработать на их продаже. Что же касается фотографий кожи, то дерматологам выгодно проводить как можно больше операций, за которые они получают деньги от государственных страховых компаний, и это может побудить их инициировать кибератаки, чтобы увеличить свой доход.

Такие атаки могут проводиться и для того, чтобы искажать результаты тестирования больных с тем, чтобы они не получали нужного им лечения.

По словам исследователей, компьютерные специалисты сейчас уже работают над созданием модели машинного обучения, которая будет защищена от мошеннических действий. Но эта сфера все еще ждет своей "золотой пули" и мы пока не имеем модели, которая обеспечит как высокую точность, так и хорошую защищенность от атак. Еще одним методом защиты является улучшение защиты самой инфраструктуры медицинских информационных систем. Финлейсон отмечает, что

Самой большой трагедией, которую я могу себе представить, будет, если кто-то посчитает само существование таких "враждебных образцов" доказательством того, что системы на базе машинного обучения не должны разрабатываться и использоваться в здравоохранении.