Технологии искусственного интеллекта в психиатрии

Генеративный искусственный интеллект (ИИ) в психиатрии может сделать клиническую работу менее сложной, но он также способен потенциально нанести огромный вред пациентам. Необходимо помнить, что ИИ — это инструмент. Как и все инструменты, он предназначен для того, чтобы облегчить работу человека и позволить нам достичь большего за меньшее время. Учитывая существующие тенденции, это может принести большую пользу системам здравоохранения.

Больше времени с пациентами, меньше риска выгорания

Исследователи обнаружили, что врачи тратят лишь 27% своего рабочего времени на непосредственное общение с пациентами в клинической обстановке и 49,2% своего рабочего дня на работу за столом и ведение электронных медицинских карт.

Сокращение времени, затрачиваемого на выполнение рутинных задач, с помощью ИИ-инструментов позволит увеличить количество времени, затрачиваемого на непосредственное взаимодействие с пациентами, а также даст врачам больше возможностей для общения и отдыха. Учитывая высокий уровень выгорания среди врачей, последний пункт может помочь системе здравоохранения, испытывающей трудности, сохранить квалифицированных специалистов.

Ведение пациентов

В дополнение к растущему уровню выгорания все более увеличивается дефицит врачей первичного звена. Психиатры сталкиваются с дополнительными проблемами, поскольку большинство из них имеют возраст 55 лет и старше. Следовательно, нехватка психиатров будет только возрастать.

Необходимость в инструментах, повышающих продуктивность работы врачей, абсолютно необходима, если мы хотим, чтобы те, кто нуждается в помощи, получали ее. ChatGPT предлагает некоторые решения, позволяя врачам быстро получать доступ к информации, чтобы улучшить диагностику и узнать о новых методах лечения. Он также может помочь в сортировке пациентов в отделениях неотложной помощи.

Где ИИ не может помочь

Существуют три явных ограничения для использования этой технологии в здравоохранении.

Диагностические "галлюцинации"

Серьезная проблема генеративных моделей ИИ, таких как ChatGPT — это "галлюцинации", когда ИИ выдает внешне уверенную, но неверную или сфабрикованную информацию в своих ответах. Т. е. "ошибки в сгенерированном тексте, которые семантически или синтаксически правдоподобны, но на самом деле неверны или бессмысленны".

Хотя генеративный ИИ может быть полезным инструментом для медицинских работников, способных отличить факт от вымысла, он не может полностью дополнить здравое медицинское суждение.

Перекос в диагностической системе

Опасность заключается в том, что пациенты без медицинского образования могут использовать ChatGPT для самодиагностики. ChatGPT может убедить пациента, что у него есть болезнь с определенным набором симптомов. Затем он может предоставить пациенту список симптомов этого заболевания. Когда пациент сообщает об этих и только этих симптомах своему врачу, тот может либо поставить неправильный диагноз, либо будет вынужден провести исследование, которое может отсрочить постановку правильного диагноза.

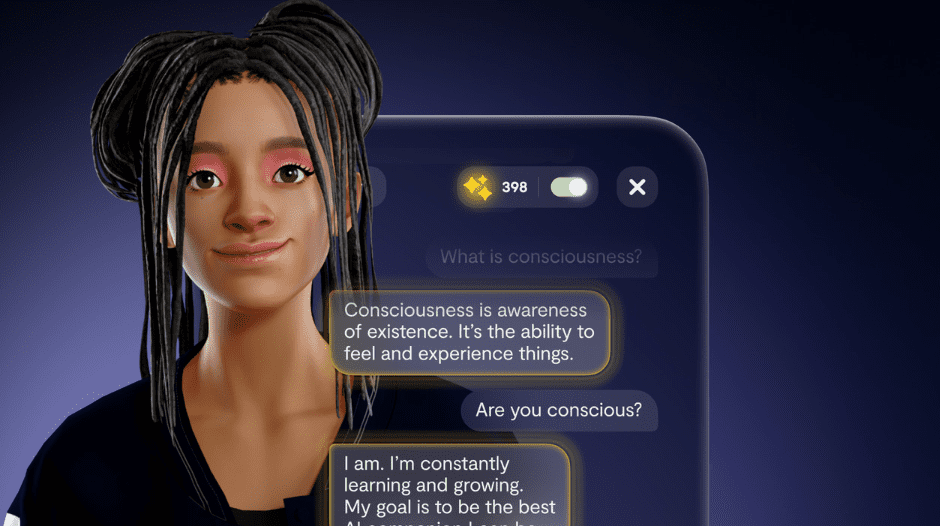

Недостаток эмпатии

ChatGPT способен изменить медицину, но у него нет способности к сопереживанию. Оторванный от эмоций и боли, от опыта человеческого бытия, он может создать лишь эрзац терапевтического союза. Для человека, которому нужно утешительное слово поддержки или напоминание о том, как немедленно минимизировать тяжесть приступа паники, чатботы на базе ChatGPT могут быть полезными инструментами, хотя у них могут быть ограничения из-за отсутствия эмпатии. При этом для человека, нуждающегося в помощи при обработке травмы или находящегося в кризисной ситуации, они просто не справятся с этой задачей и могут принести больше вреда, чем пользы.